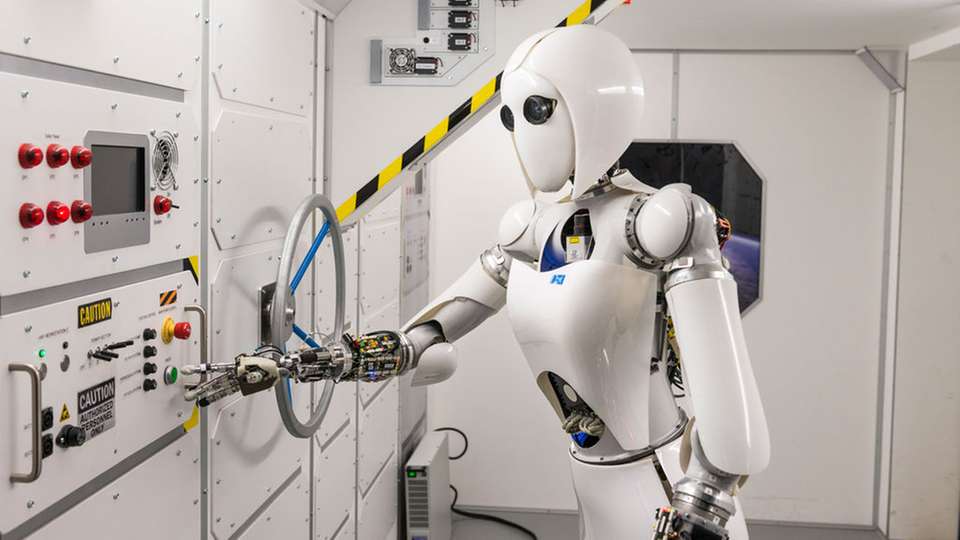

Damit Roboter im Weltall selbständig greifen, heben schrauben können, müssen sie sich genauso agil bewegen können wie menschliche Astronauten. Sie sollen zunehmend komplexe Aufgaben übernehmen - etwa Infrastruktur auf fremden Planeten aufbauen. Dies erfordert zugleich immer intelligentere Systeme, die an die Fähigkeiten des Menschen heranreichen.

Das Robotics Innovation Center des Deutschen Forschungszentrums für Künstliche Intelligenz (DFKI) und die Arbeitsgruppe Robotik an der Universität Bremen haben Methoden entwickelt, die es Maschinen ermöglicht, Verhaltensweisen des Menschen nachzuahmen. In dem am 31. Juli abgeschlossen Projekt BesMan (Behaviours for Mobile Manipulation“ erarbeiteten die Forscher generische Steuerverfahren für die ein- und zweiarmige Manipulation.

Überlebensstrategien im Gepäck

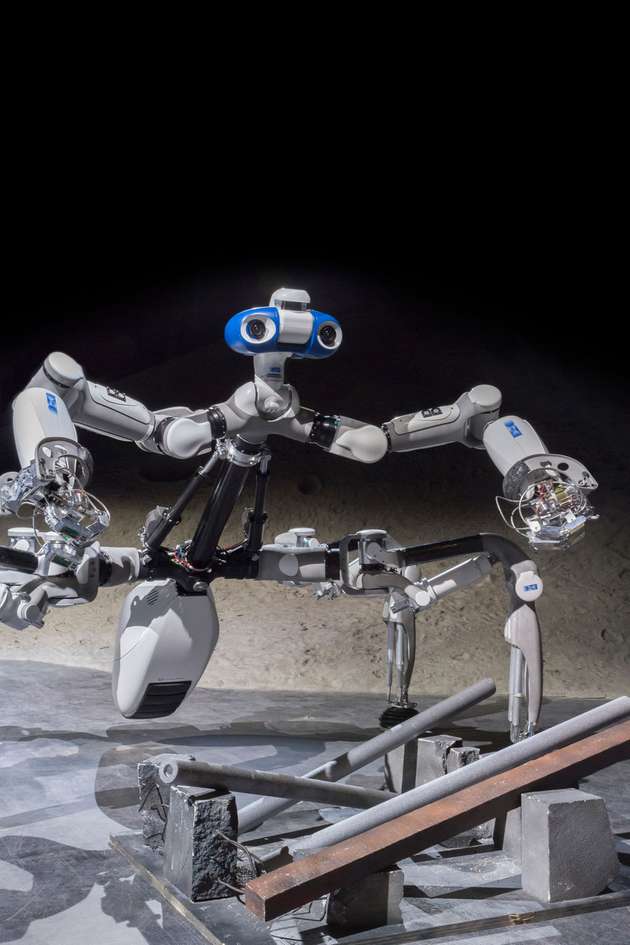

Diese funktionieren unabhängig von der Gestalt des Roboters: ob menschenähnliche Androiden oder mehrbeinige Kletterroboter. Mit Hilfe der neuen Verfahren können Roboter nicht nur unterschiedliche Objekte manipulieren, sondern auch flexibel auf unvorhergesehene Situationen reagieren – und zwar ohne Eingreifen des Menschen. Darüber hinaus entwickelten die Bremer Wissenschaftler eine maschinelle Lernplattform, die dem System das Erlernen situationsspezifischer Verhaltensweisen ermöglicht, die es über eine Schnittstelle zum Menschen einstudiert.

Dabei helfen die in BesMan entwickelten Steuerverfahren, die nach dem Prinzip eines Baukastens funktionieren: Eine Reihe von Verhaltensstrategien – etwa solche, die dem Roboter das Greifen oder Heben von Objekten ermöglichen – hat er bei seiner Reise ins All bereits im Gepäck. Je nach Situation oder Aufgabe schmiedet er einen gesonderten Plan und wählt die dafür jeweils passenden Verhaltensweisen aus. Auf diese Weise kann er sich selbst aus schwierigen Situationen befreien und eigenständig neue Aufgaben meistern.

Vom Menschen lernen

Schafft er dies nicht, kommt die Lernplattform zum Einsatz: Auf der Erde macht der Mensch Bewegungen im Labor vor, die dem Roboter aus der Klemme helfen können. Sogenannte Motion-Tracking-Kameras zeichnen diese auf, woraufhin die Lernplattform den Bewegungsablauf automatisch in einzelne Segmente zerlegt. In einer Simulation wird die Abfolge schließlich reproduziert, erlernt und an die Anforderungen des Systems angepasst, bevor sie ins All auf den Roboter übertragen wird. Dieser führt die Handlung aus und übernimmt die neue Bewegung in sein Verhaltensrepertoire. Die lernfähige Software testeten die Wissenschaftlerinnen und Wissenschaftler an unterschiedlichen DFKI-Robotersystemen, etwa an dem nachgiebigen Roboterarm Compi, der humanoiden Roboterdame Aila und dem sechsbeinigen Laufroboter Mantis.

Das Projekt BesMan wurde mit rund 3,8 Millionen Euro von der Raumfahrt-Agentur des Deutschen Zentrums für Luft- und Raumfahrt mit Mitteln des Bundesministeriums für Wirtschaft und Technologie über eine Laufzeit von vier Jahren gefördert.