Obwohl kollaborative Roboter, kurz Cobots genannt, viel Aufmerksamkeit wecken, beträgt ihr Anteil an den Industrierobotern nur knapp 3,5 Prozent. Sie sind aber das am schnellsten wachsende Segment der industriellen Automatisierung. Laut der Robotic Industries Association (RIA) soll sich der Anteil bis 2025 auf 34 Prozent des gesamten Umsatzes mit Industrierobotern verzehnfachen.

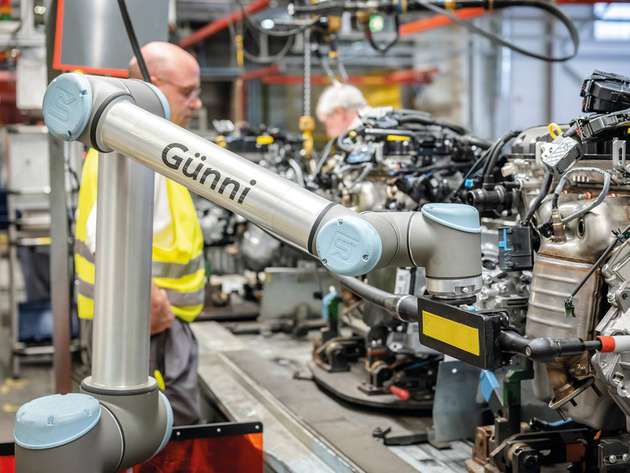

Momentan sind Cobots oft in Pilotanwendungen zu finden. So schraubt der UR1 von Universal Robots (UR), genannt Günni, in der Opel-Montage fleißig Klimakompressoren an Motorblöcke und bei Baumruk & Baumruk beschicken zwei Cobots von UR eine Fräsmaschine mit Bauteilen. Auch bei Stihl steht ein Cobot, ein Fanuc CR-35iA, liebevoll Hulk genannt. In der Verpackungslinie muss er einen 10 kg schweren Scheibenschneider von einem Hängeförderer nehmen, einem Schütteltest unterziehen und ihn bis zu einer Sichtprüfung schwebend halten.

Cobots übernehmen unergonomische Aufgaben, arbeiten im 24/7-Takt und setzen menschliche Arbeiter für andere Tätigkeiten frei, was den Fachkräftemangel mindert. Dass man keine ausgebildeten Experten braucht, um Cobots zu programmieren, ermöglicht kleinen und mittelständischen Unternehmen den schnellen Einstieg in die Automatisierung. Allerdings sind die obigen Tätigkeiten letztlich nur kooperativ, nicht kollaborativ, und das gilt laut der International Federation of Robotics (IFR) für die meisten Coboteinsätze.

Gefahr erkannt, Gefahr gebannt

Vor dem Coboteinsatz steht eine ausführliche Sicherheitsanalyse an. „Stand der Technik sind Cobots für kleine Traglasten meist bis 10 kg. Da sie im Sinne der Maschinenrichtlinie unvollständige Maschinen sind, ist grundsätzlich eine Sicherheitszertifizierung für das Gesamtsystem durchzuführen“, fasst Dr. Christian Henke, Wissenschaftler am Fraunhofer-Institut für Entwurfstechnik Mechatronik IEM zusammen. Außerdem arbeitet man mit sehr langsamen Abläufen, um ohne Lichtschranken oder Schutzzäune auszukommen und das mindert die Rentabilität.

Um Cobots sicher zu machen, verfügen sie über smarte Sensorik, wie etwa feinfühlige Kraft-Momenten-Sensoren und eine sensible Peripherie. Dr. Susanne Bieller, Generalsekretärin des IFR, weiß: „Auch wenn es schon sehr effiziente Lösungen gibt, Probleme gibt’s immer, etwa bei Endeffektoren.

Denn auch ein sonst sicherer Cobot kann, wenn er greift, zum Sicherheitsproblem werden.“ Schunk hat hier ein geeignetes Greifersystem auf den Markt gebracht. Die am Finger wirkende Greifkraft ist auf einen Maximalwert von 140 N begrenzt. Das Smarte daran: Er unterteilt den Greifprozess in einzelne Phasen mit jeweils eigenen Sicherheitsvorgaben.

Die Intelligenz funktioniert natürlich aber nicht nur in einer Richtung. „Greifer von morgen melden immer mehr Daten zurück“, beschreibt Schunk-Entwicklungschef Prof. Markus Glück den Trend. Bei diesem Smart Gripping sammeln Inline-Messsysteme Daten, werten sie mithilfe der in den Greifer integrierten Edge-Technologie aus und geben sie etwa an die Anlagensteuerung, an das ERP-System, etc. weiter.

Eine weitere Herausforderung ist es, Anwendungen cobottauglich zu machen: Der Cobot ist langsam, wenn eine Kollision mit einem Menschen möglich ist; schnell geht nur mit Schutzzaun. Die Kunst liegt darin zu optimieren, wie schnell er sein kann und wo kritische Stellen sind. Außerdem schaffen Cobots nur bescheidene Lasten, für größere benötigt man wiederum einen normalen Industrieroboter, meist mit Schutzzaun.

Und genau daher kommt das Interesse der Industrie an Cobots: Man will die teuren, sperrigen Schutzzäune loswerden. In manchen Bereichen, beispielsweise der Endmontage in der Automobilindustrie, können keine Schutzzäune aufgestellt werden, da sich der Roboter dem Arbeitsfluss anpassen muss. Außerdem ist bei der Mensch-Roboter-Kollaboration, anders als sonst bei Robotern, die Kollision zwischen beiden erlaubt, wobei bestimmte biomechanische Grenzwerte eingehalten werden müssen.

Auch müssen Cobots nicht notwendig festgeschraubt agieren. Ein von Rose+Krieger und dem Fraunhofer IEM konzipiertes dreiachsiges Portal erweitert deren Arbeitsbereich. Smarte Sensoren und Algorithmen ermöglichen dabei eine reibungslose Kommunikation zwischen Roboter und Portal.

Ein Blick in die Zukunft

Für eine echte Kollaboration muss nicht nur der Arbeiter auf den Roboter reagieren, sondern auch umgekehrt. Hier kommt die Künstliche Intelligenz (KI) ins Spiel. Im Idealfall macht sie das Programmieren der Cobots einfacher oder sogar unnötig. So könnte es durchaus möglich werden, dass der Cobot irgendwann einmal selbständig beispielsweise die Greifer auswählt und Produktionsprozesse verbessert. Die heutigen Cobots haben schon vielfach intuitive Drag-&-Drop-Programmieroberflächen, aber diese Schnittstellen sind derzeit nicht auf KI angewiesen.

In Zukunft werden dank KI Roboter in unbeaufsichtigten oder teilbeaufsichtigten Umgebungen lernen und besser mit Menschen interagieren, in dem sie zum Beispiel Sprachbefehle und Gesten erkennen. Allerdings: Die Anwendung beziehungsweise Auswertung vieler Sensordaten beruht schon heute auf KI, insbesondere bei den optischen Sensoren.

Auf in die Zukunft

Um hier gewappnet zu sein, hat sich Schunk mit AnotherBrain einen KI-kompetenten Partner gesucht. Bisher muss man für KI-Anwendungen erst mit hohem Aufwand eine Vielzahl von Daten generieren und auswerten. AnotherBrain will mit dem bionisch inspirierten Konzept der Organic AI einen neuartigen Ansatz mit dazu optimierter Hardware finden.

Statt neuer Grafikkarten präsentierte Nvidia auf der letzten Computex eine KI-Plattform für die Entwicklung autonomer Roboter für die Industrie. Dazu gehört der Jetson Xavier, ein Computer mit KI-Funktionen, der speziell für autonome Roboter entwickelt wurde. Die Bediener brauchen weder Software- noch Programmierkenntnisse – sie zeigen dem Roboter einfach, was er tun soll.

Nvidia nutzt seine Kompetenz in der physikalisch-basierten, photorealistischen Simulation. „Das Isaac Sim-Tool erstellt realistische Simulationsumgebungen, die die visuellen Eigenschaften von Objekten sowie die Kräfte und Kontakte zwischen Objekten und Manipulatoren modellieren“, berichtet Dr. Madeline Gannon, Entwicklungsingenieurin bei Nvidia.

So können Entwickler ihre Robotersoftware mit hochrealistischen virtuellen Simulationsumgebungen trainieren und testen. Dazu gehört auch der Jetson AGX Xavier, einer der ersten Computer, der eigens für die Robotik entwickelt wurde. Dieser liefert mehr Rechenleistung als eine leistungsstarke Workstation, braucht aber nur ein Drittel der Energie einer Glühbirne.

„Cobots werden immer intelligenter und mobiler, das heißt autonomer. Der nächste Schritt besteht darin, diese neuen Algorithmen und Techniken zu erproben, um sie wieder in die traditionelle Roboterautomatisierung zu überführen“, so Madeline Gannon von Nvidia. Dies verspricht dem Unternehmen zufolge das Beste aus beiden Welten: die Kombination der Vielseitigkeit, Benutzerfreundlichkeit und Sicherheit von Cobots mit der Stärke, Geschwindigkeit und Zuverlässigkeit von Industrierobotern.