Gestensteuerung ist keine Neuheit, doch die Technik ist noch längst nicht ausgereizt. Bisher funktioniert Gestensteuerung entweder per Bewegungssensor – beispielsweise beim Schütteln eines Smartphones oder eines Fitnessarmbands – oder per Kamera. ATAP (Advanced Technology and Projects), eine von Googles Forschungsabteilungen, hat nun die Gestensteuerung per Radar entwickelt und optimiert.

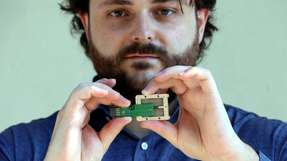

Auf der diesjährigen Google I/O, der Entwicklerkonferenz des IT-Konzerns, hat ATAP das Project Soli vorgestellt. Ziel des Projekts ist es, die Gestensteuerung von Smartwatches und anderen Geräten weiterzuentwickeln. Hierfür haben die Entwickler die Gestensteuerung per Radar für sich entdeckt. Nachdem die Technik ausgereift war, hat ATAP innerhalb von 10 Monate die Technik perfektioniert und optimiert: Der einst große Prototyp ist schließlich auf die Größe eines kleinen Chips geschrumpft.

Der Chip mit integriertem Sensor soll laut Google ATAP weit feiner arbeiten als bisherige Gestensteuerungsarten. Er ist in der Lage, Distanz, Form, Position, Grösse, Materialien und Bewegungen wahrzunehmen. Spezialisiert wurde der Chip auf Hände und deren Gesten. Insbesondere feine Bewegungen soll der Chip verarbeiten können: Das Reiben von Fingerspitzen beispielsweise kann bei einer Smartwatch das Drehen eines imaginären Rädchens simulieren. Auch das Schreiben in die Luft oder spezielle Gesten (wie das Telefon-Handzeichen symbolisch für das Annehmen eines Anrufs) sind denkbar.

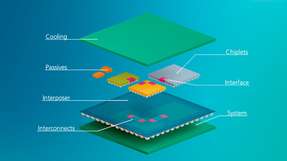

Der Chip vereint zwei Architekturen: Zur permanenten Messung wird ein FMCW-Dauerstrichradar verwendet, während ein Verfahren per Direct Sequence Spread Spectrum (DSSS) eingesetzt wird, um Störungen auszumerzen und auch schwache Signale zu erkennen. Der Soli-Chip arbeitet in einem Radarspektrum von 60 Gigahertz und kann 100 bis zu extremen 10.000 Frames pro Sekunde verarbeiten.

Der Soli-Chip soll Ende des Jahres bereits produziert werden. Genaue Angaben zu den Kosten hat Google bisher noch nicht gemacht.