Seit Jahrzehnten werden Transistoren – das Herzstück unser Computerchips – immer kleiner. Dadurch lassen sich die elekronischen Komponenten in vielerlei Geräten immer kompakter, schneller und auch leistungsfähiger herstellen. Doch kommt diese Entwicklung zu einem naturgegebenen Stillstand? Je kleiner die Bauteile, umso größer die Gefahr, dass einzelne Defekte in der atomaren Struktur das Verhalten des Bauteils deutlich verändern. Das gilt für die etablierte Siliziumtechnologie, aber auch für neuartige Nanotechnologien, die auf 2D-Materialien basieren.

An der TU Wien hat man sich in der Vergangenheit intensiv mit der physikalischen Beschreibung dieses Problems auf der Ebene der Transistoren beschäftigt. Nun geht man einen Schritt weiter und betrachtet den Einfluss der Defekte auf Ebene elektronischer Schaltungen, die manchmal aus mehreren, manchmal sogar aus Milliarden von Transistoren bestehen. In manchen Fällen ist es möglich, dass einzelne Transistoren zwar außerhalb der gewünschten Spezifikation arbeiten, als Teil einer Schaltung aus mehreren Transistoren aber immer noch gute Dienste leisten. Mit dieser neuen Betrachtungsweise auf Schaltungs-Ebene sind noch große Fortschritte bei der Miniaturisierung möglich.

Kleinere Bauteile – größere Fehler

„Die kleinsten Transistoren messen heute nur noch wenige Nanometer“, sagt Michael Waltl vom Institut für Mikroelektronik der TU Wien. „Man ist also auf die atomare Skala vorgedrungen.“ Doch Transistoren sind auf atomarer Ebene niemals perfekt: Manchmal sitzt vielleicht ein Atom an der falschen Stelle, manchmal ist die Verbindung zwischen zwei unterschiedlichen Kristallen nicht ganz exakt. „Bei größeren Bauteilen spielen solche Fehler keine so dominante Rolle, so lange sie nicht zu häufig vorkommen. Aber bei winzigen Transistoren in der Größenordnung von wenigen Nanometern kann schon ein einzelner Defekt dazu führen, dass die Kennlinien des Transistors weit außerhalb des vorgegebenen Toleranzbereichs liegen. Somit gilt er als unbrauchbar.“

Die Auswirkung von Materialfehlern im elektronischen Bauteil wird in der Industrie meist statistisch erfasst: Man stellt zehntausende Transistoren her und vermisst sie. Auf Basis der so ermittelten Variabilität kann man dann berechnen, ob diese Transistoren verwendbar sind, oder ob man die Geometrie oder den Produktionsprozess anpassen und die Fehleranzahl verringern muss. Im schlimmsten Fall müsste man dann etwa die Fläche des Chips vergrößern – das kann sich negativ auf die Leistungsfähigkeit und den Preis des Chips auswirken.

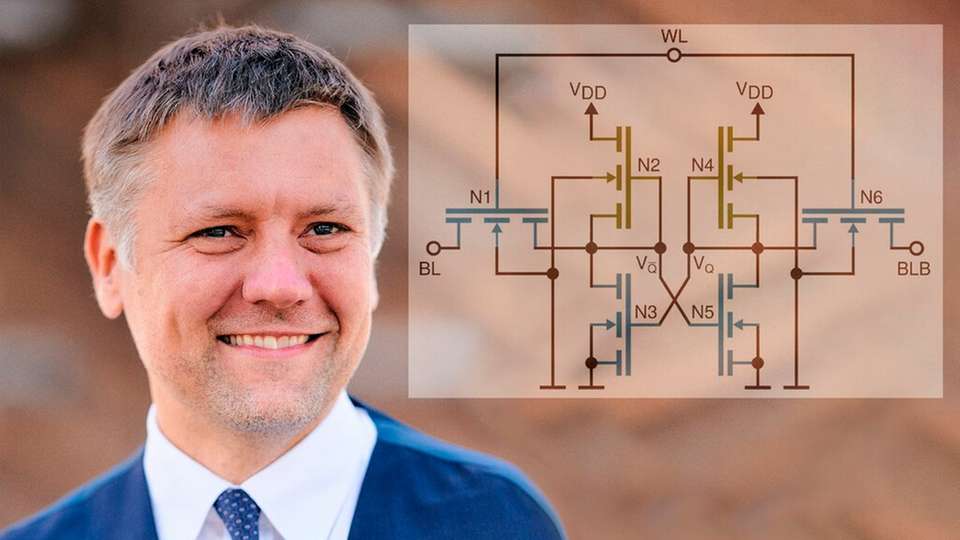

„Das alleinige Suchen nach Transistoren mit Eigenschaften außerhalb des gewünschten Parameterbereichs ist aber eigentlich eine allzu vereinfachte Sichtweise“, findet Waltl. „Die Transistoren sind ja schließlich zu einer elektronischen Schaltung zusammengeschlossen – etwa zu einem Inverter, der ein Signal umkehrt, oder einem Speicher, der zum Beispiel aus sechs Transistoren besteht. Entscheidend ist nicht die Frage, ob ein einzelner Transistor bestimmte abstrakte Kriterien erfüllt, wenn auf atomarer Ebene Fehler auftreten, sondern ob die ganze Schaltung sich dann noch korrekt verhält.“

Das Mikroelektronik-Team der TU Wien ging an dieser Frage mit einer Kombination aus Experimenten und Computersimulationen heran: Zahlreiche elektronische Bauteile wurden untersucht, auf Basis der Ergebnisse wurden aufwändige Computermodelle erstellt.

Präzise Computermodelle erlauben es, Schaltungen robust zu gestalten

Dabei zeigte sich: Auch fehlerbehaftete Transistoren sind nicht notwendigerweise nutzlos. „Die Fehlertoleranz hängt von der Schaltung ab – und das sollte man beim Design von Schaltungen unbedingt berücksichtigen“, sagt Waltl. „Es kann zum Beispiel sein, dass der Transistor an einer ganz bestimmten Stelle der elektronischen Schaltung besonders fehlerarm sein muss, dass bei einem anderen Transistor derselben Schaltung die Toleranzen aber größer sind.“ In so einem Fall könnte man eben zwei unterschiedliche Typen von Transistoren einsetzen, um sicherzustellen, dass die Schaltung am Ende ihre Aufgabe zuverlässig erfüllt.

„Unsere Ergebnisse treffen sowohl auf Silizium-Transistoren als auch auf neuartige 2D-Halbleiter zu“, sagt Waltl. „Welche Technologie man auch immer verwenden möchte, um die nächste Generation von Chips mit noch kleineren Bauteilen zu realisieren: Man sollte die Auswirkung unvermeidlicher Fehler jedenfalls nicht wie bisher nur empirisch beschreiben sondern auf physikalische Komputermodelle zurückgreifen um Teilschaltungen oder ganze Schaltungen zu simulieren, um das Beste aus den neuen Möglichkeiten herauszuholen.“