Innerhalb des großen Rahmens des computergestützten Sehens hat in den letzten Jahren die Untergruppe Embedded Vision (EV) dank zunehmender Miniaturisierung, drastisch gestiegener Rechenleistung bei gleichbleibend geringer Leistungsaufnahme und sinkenden Preisen besondere Beachtung und Verbreitung gefunden. Ihre Basis bilden intelligente Halbleiterbausteine: Mikrocontroller, CPLDs,

FPGAs oder ASICs. Sie wächst überproportional. Eine randscharfe Abgrenzung gegenüber der klassischen Bildverarbeitung ist allerdings schwierig.

Prinzipiell ist die Wirkungsweise von EV gleich der der bekannten Bildverarbeitung: Kameras erzeugen Bilder, Software wertet sie automatisch aus. Bei EV kommen aber noch weitere Schritte hinzu. Bildverarbeitungssysteme prüfen Qualität, führen Maschinen und Geräte, steuern Abläufe, identifizieren Bauteile, lesen Codes und liefern wertvolle Daten etwa zur Optimierung, Beschleunigung, sicheren Erfassung und Einstufung der jeweiligen Anwendung.

Was ist Embedded Vision?

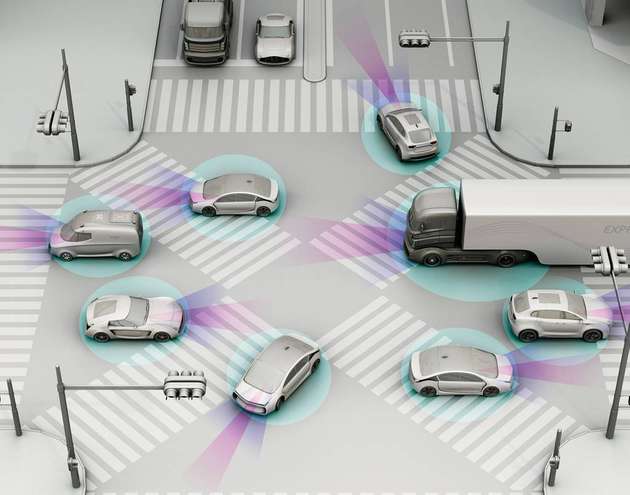

Grundsätzlich versteht man unter Embedded Vision eine kompakte Bildverarbeitungsfunktionalität, die durch Fortschritte in der Miniaturisierung der Kameramodule immer einfacher in unterschiedliche Anwendungen und Geräte eingebettet wird, beispielsweise in Maschinen, in den Roboterarm, ins Mobiltelefon oder als Fahrerassistenzsystem im Auto. Mit anderen Worten: Mit Embedded Vision lernen Maschinen und Geräte aller Art sehen.

Der Begriff Embedded Vision besagt also, dass die Bildverarbeitung, gleich welcher Art, innerhalb eines Geräts stattfindet. Sie kann in einer Vielzahl von Formaten und Technologien präsentiert werden, aber dahinter steckt fast immer die Idee, eine Lösung so einzubetten, dass sie so effizient wie möglich läuft: in einem kompakten Format, typischerweise auf ARM- oder x86-basierten Prozessoren. Häufig gibt das System ausschließlich das Verarbeitungsergebnis aus, so dass die Datenbandbreite mit der realen Welt minimiert wird und nur die Kerninformationen präsentiert werden, die das System benötigt.

Diese Schlüsseltechnologie kommt also nicht nur im weltweiten Automationswettlauf der klassischen Industriezweige verstärkt zum Einsatz, sondern erobert auch völlig neue Branchen. Verbesserte Qualität, höhere Zuverlässigkeit, mehr Sicherheit und Wirtschaftlichkeit sind Eigenschaften, die in den nichtindustriellen Einsatzfeldern ebenso gefragt sind wie in der industriellen Fertigung.

Bisher konzentriert sich der Einsatz von Embedded Vision dabei auf Transport, Logistik, Medizin und die automatische Fahrzeugführung. Die Experten sagen voraus, dass diese und ähnliche Bereiche in zunehmend schnellerem Tempo wachsen werden, da unsere Welt immer mehr Automatisierung und Datenrückmeldungen zu allen Aspekten unseres Lebens verlangt.

Embedded-Vision-Systeme: die Bestandteile

Ein Embedded-System besteht aus drei Hauptelementen (außer Beleuchtung und Linsen):

Prozessorplatine – Typischerweise basiert diese auf ARM- oder x86-Prozessoren. Es gibt mehrere populäre Optionen wie Nvidia Jetson, Raspberry Pi, Microzed und Odriod. Microzed zum Beispiel verwendet einen Xilinx Zync SoC. Dieser Baustein vereint die Softwareprogrammierbarkeit eines ARM-basierten Prozessors mit der Hardwareprogrammierbarkeit eines FPGAs und ermöglicht so Schlüsselanalysen und Hardwarebeschleunigung bei gleichzeitiger Integration von CPU-, DSP-, ASSP- und Mixed-Signal-Funktionalität auf einem einzigen Baustein.

Software – Sie wird meist speziell dafür entwickelt, um eine bestimmte Aufgabe sehr effizient auszuführen. Abhängig von der Plattform werden Kenntnisse in C und C++, FGPA- und DSP-Programmierung vorausgesetzt. Die Funktionen können von Grund auf neu geschrieben werden, möglich ist es allerdings auch, die Leistungsfähigkeit von Drittanbieter-Bibliotheken zu nutzen.

Sensor und Kamera – Ein Bildverarbeitungssystem benötigt ein Bild! Das kann von einer handelsüblichen Platinen- oder Kleinkamera kommen, die mit vielen Funktionen ausgestattet und sehr kompakt ist. Eingesetzt werden aber auch kundenspezifische Sensor-Interface-

Kombinationen.

Enorme Vorteile bei EV-Systemen mit SoCs

Auf dem Automation 4.0 Summit während der SPS IPC Drives 2017 zeigte Peter Keppler, Vertriebsdirektor von Stemmer Imaging, dass bei maßgeschneiderten EV-Systemen auf Basis von SoCs die Vorteile noch eindrucksvoller und nachhaltiger sind:

Einfache Adaption aller Bildsensoren über Standardkameras (GigEVision, USB3Vision, MIPI)

Lokale Vorverarbeitung und Datenreduktion mit leistungsstarker Hardware (FPGA, GPU, DSP)

Standardkonforme Bildverteilung zur Weiterverarbeitung mit Fernsteuerung (GigEVisionServer)

Standardkonforme Maschinenkommunikation (OPC UA)

Sourcecode-kompatibel zum PC-System (Qt, Cmake, Python)

Kompakte Bauform, einfache Integration, niedrige Stromaufnahme

Geringe Anfangsinvestition, geringe Systemkosten, einfache Duplizierung

Automotive – Haupttreiber von EV

Derzeit breiten sich EV-Systeme besonders in fortschrittlichen Fahrerassistenzsystemen (ADAS) von Automobilen aus. Das hat mehrere Gründe: Zum einen ermöglichen die hohen Stückzahlen eine rasche Amortisation, zum anderen sind EV-Systeme zwingende Voraussetzung für die angepeilten autonomen Fahrzeuge. Allerdings stellt dieser Einsatzbereich extrem hohe Anforderungen in puncto Sicherheit. Von der absolut fehlerfreien Funktion der Systeme hängen schließlich unmittelbar Menschenleben ab.

Das gilt auch für die Medizintechnik, die ebenfalls sehr hohe Sicherheitsfunktionen verlangt. Ebenfalls mit hohem Potenzial folgen intelligente Überwachungseinrichtungen sowie interaktive Anzeigentafeln. Darüber hinaus Gaming, wo der Joystick wegfällt, sowie die Mensch-Maschine-Kommunikation.

Künftig erkennen EV-Systeme, was sie sehen

Eingebettete Bildverarbeitungssysteme werden in Zukunft ein wichtiger Teil unseres Lebens sein, und maschinelle Lernfähigkeiten treiben das Potenzial dieser bildgebenden Systeme weiter voran. Dabei werden sich die Embedded-Vision-Systeme in naher Zukunft grundlegend verändern.

Das maschinelle Lernen wird eingebettete Bildverarbeitungssysteme, wie wir sie bislang kennen, verändern und zu Produkten mit völlig neuen und fast futuristischen Fähigkeiten führen: Deep-Learning-Algorithmen können dazu beitragen, dass Embedded-Vision-Systeme tatsächlich erkennen, was sie sehen, nachdem man ihnen das Muster und die Parameter verschiedener Objekte beigebracht hat. Ein Schritt weiter, mit künstlicher Intelligenz und künstlichen neuronalen Netzen (CNN) könnte sich dieses Konzept sogar auch auf den Inhalt eines Bildes erstrecken. Das Erkennen und Unterscheiden zum Beispiel eines Babys von einem Teddybären auf einem Bild ist eine beeindruckende Fähigkeit für Maschinen.

Die Embedded-Bildverarbeitung entwickelt sich rasch weiter und schafft einen immer größeren Nutzen für die Anwender. Die Informationstiefe wird zunehmen, etwa durch Farberkennung, hyperspektrale Kameras und dreidimensionale Erfassung, die EV-Lösungen werden benutzerfreundlicher, noch höher inte-

griert und leistungsstärker. Kurzum: Der bestehende Boom wird sich nicht nur fortsetzen, sondern eher noch beschleunigen.

.jpg)