In den vergangenen 10 bis 15 Jahren haben sich NAND-Flash-Speichermedien als bevorzugte Geräte für die Speicherung von Daten etabliert. Ob als Bootmedien, Audio-/Videoaufzeichnungsdatenträger, für die Datensicherung, Protokollierung oder Applikationserweiterungen – mit höheren Performance-Anforderungen und Speicherkapazitäten hat die Popularität von NAND-Flash stark zugenommen.

Der einzige Aspekt, der mit dieser Entwicklung kaum mithalten konnte, betrifft das Thema Zuverlässigkeit. Denn oftmals bleibt aufgrund sehr kurzer Einführungszyklen für neue Produkte nicht mehr genügend Zeit, um die komplexen Funktionalitäten und neuen Fehlermechanismen vollständig zu testen und zu überprüfen. Die Folge sind oft unausgereifte Produkte. Um Schwächen zu beheben, sind dann nicht selten mehrfache Firmware-Updates nötig. In den meisten Fällen werden solche Vorfälle allerdings gar nicht erst veröffentlicht, Probleme mit NAND-Speichern bleiben ein Geheimnis der Hersteller. Es sei denn, der Schaden betrifft die breite Öffentlichkeit. So musste beispielsweise Tesla im Jahr 2021 rund 134.000 Autos zurückrufen – ein unterdimensionierter eMMC-Speicher hatte frühzeitig versagt.

Geht es um SSD-Versagen, müssen zwei Hauptaspekte berücksichtigt werden: die Hardware und die Firmware. Die Hardware definiert die Bitfehlerrate (Prozentsatz der Bitfehler in den gelesenen Daten, bevor sie die Fehlerkorrektureinheit passieren), die Lebensdauer der Zellen und den unterstützten Temperaturbereich. Die Firmware hingegen muss für die gleichmäßige „Abnutzung“ des Flashs sorgen, Bitfehlerkorrekturen durchführen und Temperatureffekte sowie Datenverlust durch plötzliche Stromausfälle abmildern.

Ungenügende Qualität

NAND-Flash ist ein Massenprodukt und muss niedrige Kosten pro Gigabyte aufweisen. Viele Entwicklungen (3D-NAND, QLC) sind hauptsächlich auf dieses Ziel ausgerichtet. Für den Einsatz in Smartphones, PCs oder Laptops ist NAND in einer guten Qualität absolut ausreichend. Das gilt allerdings nicht für anspruchsvollere Anwendungen im Automotive-, Industrie-, Netzwerk- oder Telekommunikationsumfeld. Die Standardisierungsorganisation JEDEC hat dafür sogenannte Anwendungsprofile und deren jeweilige Qualitätsanforderungen definiert:

Anwendungsprofil: Client

Typische Heim-PC-Benutzung, 8 Stunden/Tag, 40 °C, nicht korrigierbare Fehlerrate (Uncorrectable Bit Error Rate, UBER) < 10-15

Anwendungsprofil: Enterprise

Typische Datenbankanwendung, 24 Stunden/Tag, 55 °C, nicht korrigierbare Fehlerrate (UBER) < 10-16

Sowohl 10-15 als auch 10-16 sind auf den ersten Blick niedrige Zahlen. Und doch bedeutet der Unterschied, dass ein Client-Laufwerk zehnmal häufiger ausfällt als ein Enterprise-Pendant. Beim hohen Datendurchsatz moderner SSDs ist die Wahrscheinlichkeit eines SSD-Ausfalls demnach nicht mehr vernachlässigbar. Die Bitfehlerrate des heutigen NAND-Flashs vor Korrektur liegt im Bereich von 10-2 für geringwertige und 10-3 für höherwertige Technologie. Verschiedene Stufen der Fehlerkorrektur reduzieren die UBER-Rate auf die gewünschten UBER-Werte. Der Flash-Qualitätsgrad und die Stärke der Fehlerkorrektur wirken sich direkt auf den Verkaufspreis aus. Als allgemeine Regel gilt hierbei: Anwendungen, die eine niedrige Fehlerrate benötigen, sollten in keinem Fall mit günstigen Consumer-SSDs realisiert werden.

Falsches Produkt

3D-NAND-Zellen sind hochkomplexe Stapel, die aus zahlreichen Lagen bestehen. Derzeit weisen einige Produkte mehr als 170 Lagen auf. Die Herstellung erfordert das Ätzen von sehr kleinen und sehr tiefen Löchern in die sogenannte Sandwich-Schicht, die sich aus Hunderten von Polysilizium- und Siliziumoxidschichten zusammensetzt. Die Methode des Ätzens hat zur Folge, dass der untere Teil eines Lochs viel schmaler ist als der obere Teil, was zu unterschiedlichen elektrischen Eigenschaften der Bereiche führt. Dies macht das zuverlässige Auslesen verschiedener Zellen zu einer großen Herausforderung. Hinzu kommen Abweichen durch Temperaturveränderungen zwischen Lese- und Schreibvorgängen.

Nicht jedes NAND-Design ist dafür ausgelegt, ausreichend gute Daten zu liefern, wenn sich die Temperatur zwischen Schreiben und Lesen ändert. Solange sich das SSD-Produkt in einem thermisch gut kontrollierten System befindet – zum Beispiel in PCs, Laptops, Servern oder Handhelds – sind die Temperaturschwankungen zu gering, um Probleme zu verursachen. Für industrielle Anwendungen steigen die Anforderungen an ein Speichermedium erheblich, und sowohl das NAND-Design als auch die Algorithmen der Firmware müssen große Temperaturschwankungen aushalten beziehungsweise ausgleichen. Eine falsche Wahl des NVM-Speichermediums kann zahlreiche Probleme verursachen, sobald das System unter wechselnden Temperaturbedingungen arbeiten muss.

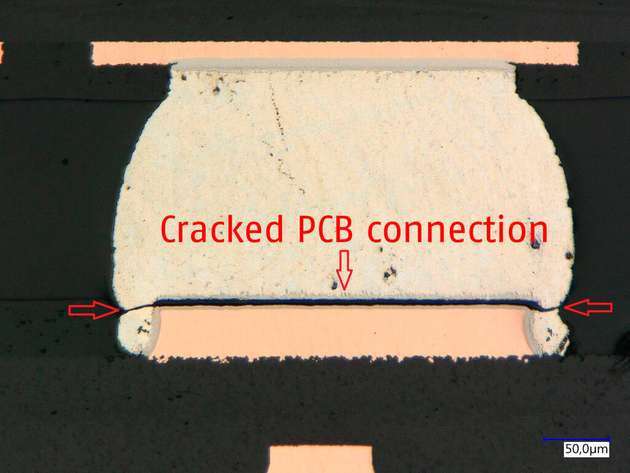

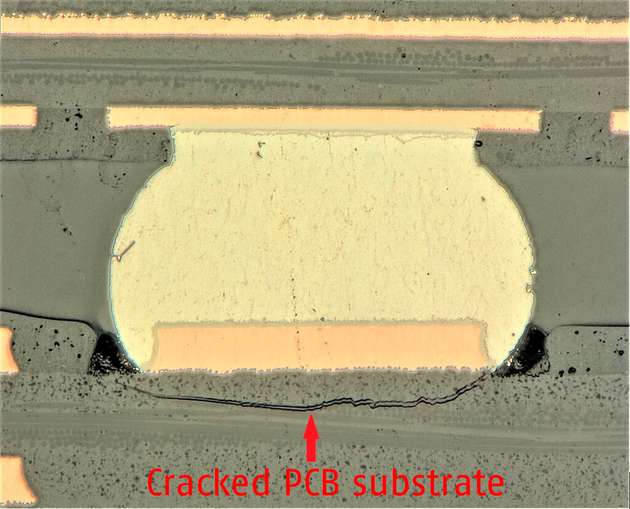

Ungenügende thermomechanische Stabilität

Eine weitere Herausforderung für moderne Speicherlösungen sind thermomechanische Materialspannungen. Sie treten auf, wenn Temperaturwechsel auf Baugruppen einwirken, in denen Bauteile mit unterschiedlichen Materialien und entsprechenden Wärmeausdehnungskoeffizienten kombiniert sind. Dies bedeutet, einige Teile dehnen sich bei der gleichen Temperaturänderung stärker aus als andere.

Da eine SSD prinzipiell aus einer Leiterplatte mit aufgelöteten Komponenten wie einem ASIC, NAND, Stecker und weiteren kleinen Bauteilen besteht, verhalten sich diese bei wechselnden Temperaturen unterschiedlich. Da diese Bauteile jedoch fest mit der Leiterplatte verlötet sind, führt dies zu unterschiedlichen Materialausdehnungen. Das wiederum kann zu mechanischen Spannungen bis hin zu einem Bruch der Verbindung führen.

Diese Verbindungsrisse treten meist erst nach mehreren Hundert bis Tausenden von Temperaturzyklen, oft erst nach mehreren Monaten oder sogar Jahren auf. Bei industriellen Systemen, die lange Zeit im Feld sind, ist diese Stabilität jedoch essentiell.

Mangelnder Schutz vor Stromausfällen

Für einen PC, der immer ordnungsgemäß heruntergefahren wird, ist ein Stromausfall in der Regel kein Problem. Bei einem medizinischen Gerät, das abrupt vom Stromnetz getrennt wird, oder einem Netzwerk-Router in einer Umgebung mit instabiler Stromversorgung ist das anders. Hier muss dafür gesorgt werden, dass ein plötzlicher Stromausfall in keinem Fall zu einem defekten System führt.

Dabei kann ein plötzlicher Stromausfall den Flash-Speicher zu jeder Zeit in unterschiedlichen Betriebsarten betreffen: während eines Schreibvorgangs auf die SSD, während der internen Restrukturierung, während eines Firmware-Updates oder sogar während der Wiederherstellung nach einem früheren Stromausfall. Behandelt die Firmware den „Power Drop“ nicht korrekt, kann ein mehr oder weniger starker und fataler Datenverlust die Folge sein.

Im besten Fall handelt es sich nur um die zuletzt geschriebenen Daten, die sogenannten „data in flight“, im schlimmsten Szenario sind die Firmware-Strukturen beschädigt und die SSD nicht mehr nutzbar. Gerade im Bereich kritischer Anwendungen ist dies nicht tolerierbar, dort kann bereits der Verlust von nur wenigen Bits schwere Folgen nach sich ziehen.

Falsche SSD-Firmware-Architektur

Für Consumer-SSDs ist die Datenübertragungsgeschwindigkeit ein entscheidender Faktor. Allerdings werden die Tests und Benchmarks hierfür in der Regel durchgeführt, wenn die Laufwerke neu, leer oder frisch formatiert sind. Dabei wird meist nicht berücksichtigt, wie viel Leistung übrigbleibt, wenn das Gerät zu 80 bis 100 Prozent gefüllt ist, mehrfach überschrieben wurde oder vielleicht bei hohen Temperaturen läuft.

Viele der vorherrschenden Firmware-Architekturen konzentrieren sich auf hohe Datenblatt-Werte, aber nicht auf die mögliche Datenbelastung über die Lebenszeit (Endurance), die Langlebigkeit der Daten (Data Retention) oder die gesättigte Geschwindigkeit über den Lebenszyklus. Im extremsten Fall kann die Auswahl einer SSD, die nicht für den langfristigen und zuverlässigen Einsatz optimiert ist, zu unvorhersehbaren Überraschungen führen, sobald der erste „Lebensabschnitt“ des SSD-Laufwerks vorüber ist.

Fazit

Die Auswahl des richtigen NAND-Speichermediums beziehungsweise SSD hängt von vielen Kriterien ab. Besonders wenn es um den industriellen oder langfristigen Einsatz sowie anspruchsvolle Anwendungen geht, sollten folgende Faktoren in den Entscheidungsprozess einbezogen werden: Performance über Zeit und Temperatur, Einsatztemperaturen und Kühlkonzepte, Spannungsversorgungsumfeld, Lebensdauerschreiblast und Überwachungsmöglichkeiten, sowie Zuverlässigkeit, Support und Qualität des Lieferanten.