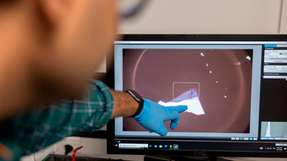

Schaut ein Nutzer auf sein Smartphone oder Tablet spiegelt sich in seinen Augen die Umgebung um ihn herum. Bewegt er nun die Hände innerhalb dieser Umgebung, erkennt das Gerät diese Bewegung und kann die entsprechenden Befehle umsetzen. Benötigt wird dafür nur die normale Frontkamera des Geräts. „Das muss also keine langfristige Zukunftsvision sein, sondern könnte schon mit der heutigen Generation von Smartphones umgesetzt werden“, erklärt Prof. Dr. Jens Grubert. Der Professor für Mensch-Maschine-Interaktion im Internet der Dinge erforscht Techniken, die die Bedienung von mobilen Endgeräten erleichtern können.

Diese Erkenntnisse zur Interaktion mit Mobilgeräten mittels Augenreflektionen stellten er und sein Mitarbeiter Daniel Schneider auf den internationalen Konferenzen IEEE International Symposium on Mixed and Augmented Reality (IEEE ISMAR) in Nantes (Frankreich) und auf der ACM International Conference on Interactive Surfaces and Spaces (ACM ISS) in Brighton (England) vor.

.jpg)