Die Speichertiefe eines Oszilloskops ist der entscheidende Faktor für die maximal mögliche Aufzeichnungszeit eines Signals bei hoher Abtastrate. Es gilt: Aufzeichnungszeit = Speichertiefe : Abtastrate. Viele Oszilloskope verfügen standardmäßig über eine Speichertiefe im einstelligen Megasample-Bereich. Verglichen mit den vor zehn Jahren üblichen Speichertiefen von einigen Kilosamplen, erscheint das angemessen. Allerdings sind für die Analyse von Komponenten auf Prüflingen und Schaltungen verschiedene Zeitskalen wichtig. Netzteile oder Steuerbusse arbeiten im Sekunden- bis Millisekundenbereich; Treiber für Ausgangsstufen hingegen schalten in Nano- bis Pikosekunden. Bei der gleichzeitigen Prüfung von zwei so unterschiedlichen Komponenten reicht oft der Erfassungsspeicher zur Analyse nicht aus.

Zu geringer Speicher für verschiedene Zeitskalen

Projektleiter planen oft mehrere Wochen ein, um neue oder bisher ungetestete Spannungsversorgungsschaltungen in Betrieb zu nehmen. Mit einer großen Speichertiefe lassen sich störende Wechselwirkungen mit anderen Schaltungsteilen beim Hochfahren des Netzteils leichter erkennen und somit schneller beheben. Durch das Netzgerät verursachte elektromagnetische Störungen, wie Übersprechen und verwandte Probleme, sind dabei von zentraler Bedeutung. Allerdings arbeitet die Schaltung oft mit voller Geschwindigkeit im Gigahertzbereich, während die Ursache des Problems häufig im Millisekunden- oder Sekundenbereich liegt. Da alle Signale gleichzeitig aufgezeichnet werden und die Zeitbasen somit gekoppelt sind, bleibt der gesuchte niederfrequente Störer bei der Analyse eines schnelleren Signals leicht verborgen. Bei einer kleinen Speichertiefe von beispielsweise 4 MSamples ist der Anwender auf maximal einige 100 MSamples/s beschränkt, um genau diesen Zeitabschnitt zu erfassen.

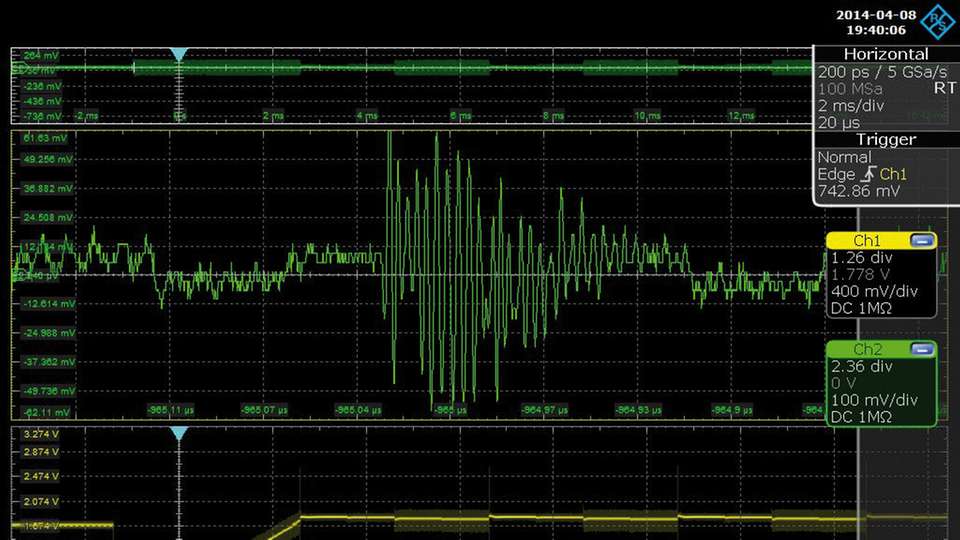

Abbildung 1 zeigt ein verrauschtes I2S-Audiosignal (Abbildung 1, oberes Diagramm). Im Zoomfenster (siehe Abbildung 1, mittleres Diagramm) offenbart sich die hochfrequente Natur des problematischen Rauschens im System. Werden die umgebenden Signale mit zu geringer Speichertiefe untersucht, lässt sich die Quelle des hochfrequenten Rauschens nicht lokalisieren. Um diese beobachten zu können, muss die Aufzeichnungsdauer verlängert und gleichzeitig die hohe Abtastrate beibehalten werden. In dem Beispiel aus Abbildung 1 stellt sich der nahegelegene Abwärtswandler von 5 auf 1,8 V als Ursache heraus. Er hat, während der einige Millisekunden dauernden Startsequenz (siehe Abbildung 1, unteres Diagramm), die gleiche Taktung wie das hochfrequente Rauschen im I2S-Signal. Die Kreuzkorrelation der Startsequenz der Spannungsversorgung mit den Hochgeschwindigkeitskanälen ist bei der Fehlersuche häufig das entscheidende Verfahren, das den Zeitplan rettet.

Prädestiniert zur Fehlersuche

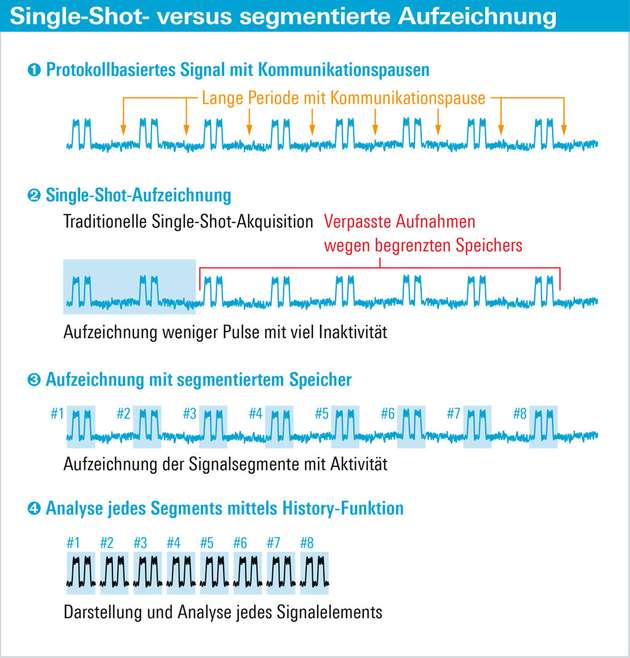

Langsame serielle Busse wie I2C, SPI, CAN oder LIN werden oft als Steuerelemente in digitalen Designs verwendet. Da sie Systemänderungen oder System-

aktionen steuern, sind sie prädestiniert zur Fehlersuche und zur Analyse des Systemverhaltens. Bei gegebenem Speicher stehen grundsätzlich zwei Vorgehensweisen zum Aufzeichnen mehrerer Bursts zur Verfügung: die Reduzierung der Abtastrate am Oszilloskop und die Erfassung mit segmentiertem Speicher.

Sobald gleichzeitig schnelle und langsame Signalen gemessen werden sollen, ist eine Reduzierung der Abtastrate notwendig. Ein Beispiel ist die gleichzeitige Messung eines I2C-Buses, der alle

19 ms ein 1 ms langes Datenpaket mit

10 kHz Bandbreite sendet (siehe Abbildung 2, Punkt 1) und des dadurch ausgelösten Puls. Die Kunst besteht darin, die Abtastrate so zu wählen, dass sie niedrig genug ist, um zum einen den gesamten Puls sowie genügend Datenpakete aufzuzeichnen. Zum anderen muss sie hoch genug sein, um zum Beispiel Glitches in den Datensignalen zu identifizieren.

Erschwerte Analyse

Dieser Ansatz birgt zwei entscheidende Nachteile, die die Analyse von sporadischen Fehlern, besonders für gepulste Signale mit steilen Flanken, erschweren. Der große Anteil an nicht relevanter Inaktivität (siehe Abbildung 2, Punkt 2) führt dazu, dass nur wenige relevante Protokollpakete aufgezeichnet werden. Der zweite Nachteil ergibt sich durch die notwendige Begrenzung der Abtastrate. Bei einer Speichertiefe von 4 MSamples und einer Abtastrate von 5 GSample/s liegt beispielsweise die maximale Aufzeichnungsdauer bei unter einer Millisekunde. Sie reicht somit nur für ein einzelnes Protokollpaket des Beispielsensors. Sind für die Analyse 20 Pakete und damit

400 ms nötig, lassen sich diese nur dann aufzeichnen, wenn die Abtastrate auf 10 MSamples/s verringert wird. Für eine Suche nach Signalintegritätsfehlern ist dies zu niedrig. Deshalb ist für solche Analysen ein Oszilloskop mit tiefem Erfassungsspeicher notwendig. Sind zum Beispiel 20 MSamples verfügbar, lässt sich die Abtastrate immerhin auf 50 MSamples/s anheben, die Pakete lückenlos aufzeichnen und das Signal auf Fehler untersuchen. Wird der Speicher weiter erhöht, steigt die Wahrscheinlichkeit Signalintegritätsfehler zu finden.

Erfassung mittels segmentiertem Speicher

Der zweite Ansatz besteht darin, die Aufzeichnung auf die eigentlichen Datenpakete zu beschränken. Sie wird segmentierter Speicher genannt. Da solche Aufzeichnungen keine Informationen zwischen Paketen speichern (siehe Abbildung 2, Punkt 3), kann eine hohe Abtastrate mit einer langen Aufzeichnungsdauer kombiniert werden. Oft vergrößern entsprechende Geräteoptionen den verfügbaren Speicher noch zusätzlich.

Der Vorteil dieser Variante liegt auf der Hand: Selbst bei begrenzter Speichertiefe lassen sich hochaufgelöste Details messen. Das eignet sich zum Beispiel zum Finden von Glitches. Zwei Faktoren erschweren bei dieser Vorgehensweise die Analyse. Erstens sind asynchrone Ereignisse, die zwischen den Paketen stattfinden, nicht sichtbar. Die Fehlersuche soll allerdings alle Ereignisse offenlegen, die das System beeinflussen. Deshalb ist es wichtig sicherzustellen, dass auch zwischen den Paketen auftretende Probleme erkannt werden.

Zweitens muss die Rearm-Zeit beachten werden. Die Rearm-Zeit gibt die Zeit an, die das Oszilloskop zwischen zwei Aufzeichnungen benötigt. Oft liegt diese Zeit im µs-Bereich. Bei segmentiertem Speicher verhindert die Rearm-Zeit unter Umständen die vollständige Aufzeichnung einer schnellen Folge von sequentiellen Paketen. Diese Vorgehensweise erfordert ein genaues Verständnis des seriellen Busses und seiner Arbeitsweise, um die Auswertung nicht dem Zufall zu überlassen.

Zur Selektion der Datenpakete bietet sich ein dedizierter Protokoll-Trigger auf I2C-Datenwörter an. Benutzerfreundliche Implementierungen ermöglichen es dem Nutzer, die Länge und die Zahl der Segmente flexibel an die Aufgabenstellung anzupassen. Für serielle Protokolle gibt die maximale Paketlänge im Signal die Wahl der Aufzeichnungslänge vor. Bei der anschließenden Analyse ist es wichtig, den Zeitpunkt der einzelnen Trigger-Ereignisse möglichst genau festzuhalten.

10 bis 20 MSamples als Standard

Die Speichertiefe ist ein grundlegendes Oszilloskop-Merkmal. Sie bestimmt, wie die Abtastrate in der Praxis ausgenutzt werden kann. Zu geringe Speichertiefe oder falsche Einstellungen bei Oszilloskopen mit ausreichendem Erfassungsspeicher wirken sich äußerst nachteilig auf Messungen und Fehlersuche aus.

Für heutige Messungen sind 10 bis 20 MSamples als Standardkonfiguration zumeist ausreichend. Eine höhere Speichertiefe ist bei Aufgaben interessant, bei denen das Oszilloskop zusammen mit der Segmentierung einen Protokollanalysator ersetzen soll. Hier kann es sinnvoll sein, den Speicher auf mehrere 100 MSamples aufzurüsten.

Neben einem ausreichenden Speicher ist es wichtig, die Abtastrate innerhalb des Aufzeichnungszeitraums für das jeweilige Signal zu maximieren. Bei kritischen Messungen gilt es gezielt die nötige Abtastrate zu wählen und sich nicht blind auf die automatische Konfiguration zu verlassen.