Wir alle verlassen uns heutzutage stark auf die digitale Welt, sei es beim Kauf von Waren und Dienstleistungen, beim E-Mail-Verkehr, bei finanziellen Transaktionen und vielem mehr. Dabei erwarten wir, dass unsere Transaktionen sicher sind. Die meisten Menschen gehen davon aus, dass Sicherheit hierbei eine Selbstverständlichkeit ist. Dies kann man auch in der Regel als gerechtfertigt betrachten, da Betriebssysteme und Browser auf gängigen Geräten (zum Beispiel PCs, Laptops, Smartphones und Tablets) inzwischen ausgereifte Sicherheitstechnologien bieten, die uns oft warnen, wenn etwas verdächtig erscheint.

Was die Milliarden von Knotenpunkten im Internet der Dinge (IoT) anbelangt, ist die Lage jedoch weniger sicher. Relativ einfache Geräte wie beispielsweise Babyphone wurden gehackt, um Zugang zu Videos zu erlangen. Noch besorgniserregender ist, dass sich Hacker Zugang zu vernetzten Autos verschafft haben, wodurch sie physischen Zugang zur Fahrerkabine erlangen und, was noch schlimmer ist, in Systeme wie Lenkung und Beschleunigung eingreifen können. Die Folgen liegen auf der Hand – und sind potenziell tödlich.

Wie sicher ist sicher?

Die Schwachstellen der IoT-Geräte sind nicht auf mangelnde Sicherheit zurückzuführen, denn sie verfügen über modernste Sicherheitssysteme. Vielmehr ist es die Art und Weise, wie die Sicherheit implementiert wird, die Hackern Angriffsflächen bietet. Digitale Schlüssel sind unter Umständen nicht vollständig gesichert, und aufgrund mangelnder Disziplin bei der Einrichtung wird häufig das Standard-Administrator-Passwort beibehalten.

Bildergalerie

Solange moderne Cybersicherheit richtig implementiert ist, sollte es keine Lücken geben. Mit dem aufkommenden Quantencomputing werden sich die Dinge jedoch drastisch ändern.

Was sichert die aktuelle Verschlüsselung?

Moderne Kryptografie ist keine Geheimwissenschaft; die Algorithmen werden (rechtmäßig) im Internet veröffentlicht und können von jedermann eingesehen werden. Die moderne Cybersicherheit ist in Bezug auf ihre Funktionsweise „offen“: Die Sicherheit basiert auf mathematischen Algorithmen, die in eine Richtung leicht, in die andere Richtung jedoch (nahezu) unmöglich zu berechnen sind.

Gängige mathematische Funktionen (wie zum Beispiel die Multiplikation) sind in der Regel bidirektional, das heißt sie lassen sich ebenso einfach umkehren, wie sie berechnet wurden. Wenn wir wissen, dass die Funktion einen Wert verdreifacht (mit drei multipliziert) und das Ergebnis 24 ist, können wir schnell zum ursprünglichen Wert von acht rückschließen. Diese Art von Funktion ist für die Verschlüsselung unbrauchbar, daher werden unidirektionale Funktionen verwendet, die nahezu unmöglich umkehrbar sind.

Das Thema Sicherheit gibt es schon so lange, wie es Informationen gibt. In den Anfängen der Computertechnik wurden geheime Schlüssel zum Ver- und Entschlüsseln empfindlicher Daten verwendet. Sobald sie offengelegt wurden, waren diese physisch verteilten Schlüssel unbrauchbar.

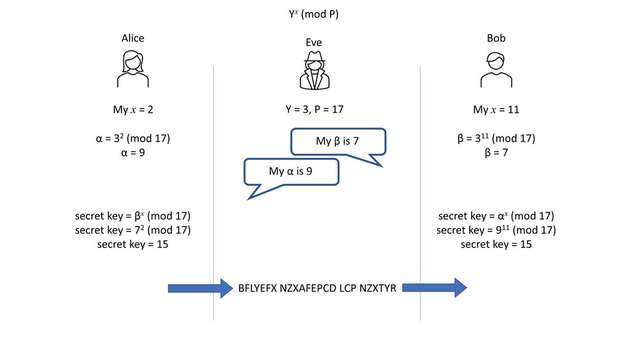

Whitfield Diffie und Martin Hellman, zwei US-amerikanische Verschlüsselungsexperten, erkannten die damit verbundenen Probleme und forschten gemeinsam an mathematischen Ansätzen, die eine vorherige Weitergabe der Schlüssel überflüssig machten. Ihre Arbeit führte zur modernen Kryptographie mit öffentlichem Schlüssel und basierte auf dem Einsatz modularer Arithmetik, durch die asymmetrische Chiffren realisierbar wurden. Dieser Ansatz wurde von Ron Rivest, Adi Shamir und Leonard Adleman zu einer asymmetrischen Chiffre weiterentwickelt, die auf Primzahlen basiert. Ein öffentlicher Schlüssel wird vom Nutzer anhand des Produkts von zwei Primzahlen erzeugt. Dieser Schlüssel kann dann von jedermann zur Verschlüsselung von Informationen verwendet werden, aber nur Personen, die die ursprünglichen zwei Primzahlen kennen, sind in der Lage, Informationen zu entschlüsseln.

Rivest, Shamir und Adleman entwickelten die asymmetrische Chiffre, die sich auf eines der schwierigsten Probleme der Mathematik stützt: die Primzahlen. Einfach ausgedrückt: Ein Nutzer erstellt einen öffentlichen Schlüssel (eine Zahl), indem er zwei Primzahlen miteinander multipliziert. Mit diesem öffentlichen Schlüssel kann jeder Informationen verschlüsseln, aber nur die Person, die die beiden ursprünglich verwendeten Primzahlen kennt, kann sie entschlüsseln.

Das Verfahren wurde nach seinen Erfindern unter dem Namen „RSA“ bekannt und wird bereits seit den 1970er Jahren verwendet, da selbst die heutige Computertechnik kaum in der Lage ist, es zu knacken. Mit den leistungsstärksten Parallelrechnern wurde ein 829-Bit-Schlüssel errechnet, was allerdings 2.700 CPU-Core-Jahre dauerte. Um die Sicherheit zu gewährleisten, empfiehlt das US-amerikanische National Institute of Standards and Technology (NIST) die Verwendung von mindestens 2048 Bits, was die Fähigkeiten aktueller Computer bei Weitem übersteigt.

Quantencomputer: die nächste Herausforderung

In der Fachpresse wird regelmäßig über die Fortschritte der Quantencomputer berichtet. Dabei handelt es sich um Maschinen, deren Bauweise und Betrieb so komplex sind, dass sie bis nahe an den absoluten Nullpunkt (0° Kelvin, -273° Celsius) gekühlt werden müssen. Die Bewältigung dieser Herausforderung scheint sich zu lohnen, denn die Rechenleistung dieser Maschinen übertrifft die Prognosen des Mooreschen Gesetzes bei Weitem.

Es gibt eine Reihe von wichtigen Anwendungsbereichen für diese künftigen Quanten-Supercomputer, insbesondere in der Chemie, Biologie und Medizin. Doch es gibt auch Befürchtungen, dass eine einzige Maschine in den Händen eines Schurkenstaates verheerenden Schaden anrichten könnte. Als sicher gilt: Mithilfe von Quantencomputern werden Berechnungen von Faktoren in nie da gewesener Geschwindigkeit durchgeführt.

Gegenwärtig arbeiten Prozessoren mit einem Algorithmus oder Programm (im Grunde eine Reihe vorgegebener Anweisungen), um die ihnen zugeführten Daten zu verarbeiten und ein entsprechendes Ergebnis zu liefern. Die Eingangsdaten und das Ergebnis werden als Binärcode (ein Datenfluss aus 1en und 0en) gespeichert. Die Fähigkeit, schnell zu rechnen, hängt vom Prozessor, seiner Taktgeberfrequenz und der Fähigkeit des Programmierers ab, einen effizienten Code zu schreiben.

Anstelle von Binärcodes verwenden Quantencomputer „Qubits“, die sich gleichzeitig in den Zuständen „0“ und „1“ befinden können. Dadurch sind sie in der Lage, bis zu 2n Berechnungen durchzuführen, wobei n = Anzahl der Qubits ist. Wenn also genügend Qubits zur Verfügung stehen, kann die Faktorisierung nahezu verzögerungsfrei durchgeführt werden (im Vergleich zu den derzeitigen Standards für die Datenverarbeitung).

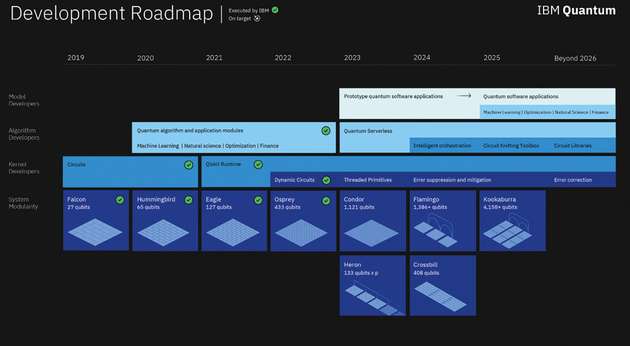

Es gibt bereits mehrere Arten von Quantencomputern, sodass direkte Vergleiche nicht einfach sind. Der Osprey-Prozessor von IBM ist jedoch schon jetzt in der Lage, 433 Qubits zu verarbeiten, und IBM hat eine Roadmap, die den Weg zu einem Prozessoren mit 4.158 Qubits innerhalb einiger Jahre zeigt. Bei einer derartigen Rechenleistung und der Verwendung von Factoring-Beschleunigern wie dem Shor-Algorithmus ist klar, dass die Verschlüsselung nicht mehr sicher sein kann, wenn sie allein aufgrund der mathematischen Berechnungskomplexität erfolgt.

Quantencomputer: Sicher oder nicht?

Auf den ersten Blick könnte man meinen, dass Quantencomputer alles in kürzester Zeit berechnen können. Doch glücklicherweise gibt es einige mathematische Aufgaben und Prozesse, die für die Quantencomputer eine Herausforderung darstellen.

Nachdem das NIST den Bedarf an quantenresistenten Verschlüsselungsansätzen erkannt hatte, rief es 2016 zur Einreichung von Applikationen für neue Algorithmen und Techniken auf, die die Verschlüsselung zukunftssicher machen könnten. Ein Teil der Herausforderung ist die große Vielfalt der heute eingesetzten Geräte, die von High-End-Computern bis hin zu Mikrocontroller-basierten IoT-Knoten mit begrenztem Speicher und nur einer kleinen Batterie oder sogar Energy Harvesting als Energiequelle reichen. Die Aufgabenstellung des NIST sollte alle Formen der Datenverarbeitung umfassen.

Nach mehreren Jahren der Entwicklung kristallisierten sich vier Post-Quantum-Kryptographie-Algorithmen (PQC) als führende Kandidaten für die Verschlüsselung heraus. Drei davon basierten auf dem äußerst anspruchsvollen LWE-Verfahren („Learning With Errors“, Lernen mit Fehlern) über Modulgittern. Einer der Ansätze, der CRYSTALS-Kyber-Algorithmus, konzentriert sich auf allgemeine Verschlüsselung und Datensicherheit in gemeinsam genutzten Netzwerken. Da dieser Algorithmus einen guten Durchsatz und kleine Schlüsselgrößen bietet, wird er weiter entwickelt und unter anderem auf einem Arm Cortex-M4-Prozessor geprüft. Die beiden anderen LWE-basierten Ansätze, die es durch die NIST-Prüfung geschafft haben, sind der CRYTALS-Dilithium-Ansatz und der FALCON-Ansatz, die in erster Linie auf digitale Signaturen abzielen.

Derzeit scheinen diese Ansätze noch „quantensicher“ zu sein, aber es ist wenig darüber bekannt, wie sich die Quanteninformatik entwickeln wird, sodass sie in der Zukunft geschwächt oder vollständig kompromittiert werden könnten, was weitere Technologien zur Aufrechterhaltung der Sicherheit erfordert.

Der letzte Algorithmus, der die NIST-Prüfung durchlaufen hat, ist SPHINCS+, der auf einer zustandslosen, hashbasierten Signatur basiert. Dieser Ansatz ist langsamer als die anderen und benötigt mehr Speicher. Im Detail bedeutet das, dass er für die Embedded-Systeme, die häufig in IoT-Knoten zu finden sind, weniger geeignet ist.

Vorbereitung erforderlich

Die vier vom NIST ausgewählten Algorithmen sind sehr vielversprechend, aber sie sind noch nicht bereit für einen groß angelegten Einsatz, da für den Einsatz in neuen Geräten mit Secure Element (SE) und Trusted Platform Module (TPM) neue Hardware-Beschleuniger benötigt werden, die eine Weiterentwicklung der Halbleiter voraussetzen. Dennoch kann man viel tun, um sich auf die Zukunft der PQC vorzubereiten.

Eine der wichtigsten Maßnahmen ist die sorgfältige Überprüfung der bestehenden Sicherheit. Sicherheitslücken, die heute auftreten, sind nicht darauf zurückzuführen, dass die Verschlüsselung geknackt wurde, sondern auf Schwachstellen in den Verfahren. Schwachstellen können alles sein, von der Beibehaltung des Standard-Administrator-Passworts auf einem handelsüblichen Gerät bis hin zu unverschlüsselten Datenströmen innerhalb von Systemen, die abgefangen werden können. Hacker sammeln alle Daten, die sie bekommen können. Selbst wenn es jetzt noch nicht zu einer Sicherheitslücke kommt, können die Daten für einen späteren Zeitpunkt gespeichert werden, wenn das Quantencomputing verfügbar ist. Auch der hohe Preis wird kein Hindernis sein, da die Technologie voraussichtlich als stundenweise verkaufter Cloud-Dienst verfügbar sein wird.

Sobald die Prozesse geprüft und sicher sind, mit nicht offensichtlichen Passwörtern versehen sind, ist der nächste zu prüfende Bereich die eingesetzte Hardware und Software. Überprüfen Sie anhand der Herstellerangaben, ob die vorhandene Verschlüsselungstechnologie integriert ist.

So eignen sich beispielsweise die ATECC608B-Bauteile von Microchip Technology für eine Reihe von Applikationen im Bereich Sicherheit, denn sie ermöglichen die Identitätsauthentifizierung, die Erstellung von Sitzungsschlüsseln und die Gewährleistung eines sicheren Startvorgangs. Diese fortschrittlichen CryptoAuthentication-Co-Prozessoren speichern 16 Schlüssel oder Zertifikate sicher und bieten Beschleunigung für asymmetrisches Signieren und Verifizieren mit Elliptic Curve Cryptography (ECC). Zur Unterstützung der Entwicklung stehen Tools zur Verfügung, darunter das Hardware-Evaluierungsboard der CryptoAuth Trust Platform mit der Software CryptoAuthLib von Microchip.

Darüber hinaus ermöglicht das Development Kit OM-SE050ARD von NXP eine schnelle Evaluierung mit einem Arduino-kompatiblen Development Board. Dieses wertvolle Development Tool enthält ein sicheres Element SE050 EdgeLock von NXP und ist damit für IoT-Sicherheitsaufgaben geeignet (und einsatzbereit), einschließlich TLS-Verbindungen, Schutz von Sensordaten, sicherer Zugriff auf IoT-Knoten/‑Services und mehr. Für die sichere Speicherung von Daten oder Schlüsseln steht ein User-Flash-Speicher (50 kB) zur Verfügung. Zusätzlich werden asymmetrische (RSA und ECC) und symmetrische (AES und DES) Algorithmen unterstützt und der SE050 ist nach Common Criteria EAL6+ zertifiziert.

Die Development Boards OPTIGA TPM und TPM 9645 IRIDIUMBOARD von Infineon sind für den Schutz der Integrität und Authentizität von Geräten und Systemen in Embedded-Netzwerken konzipiert. Die Hardware erfüllt die Anforderungen TPM 1.2 Rev. 116 der Trusted Computing Group (TCG) und die Kodierung ist nach Common Criteria EAL4+ zertifiziert. Die 26- und 28-poligen Stiftleisten des Boards ermöglichen einen einfachen Zugang und sind kompatibel für die Evaluierung mit einem Raspberry Pi oder BeagleBone. Das kleine 5,0 mm × 5,0 mm große VQFN-32-Gehäuse weist einen niedrigen Stromverbrauch von nur 110 µA im Ruhezustand auf, wodurch es sich für IoT-Applikationen eignet, bei denen die Stromversorgung begrenzt ist.

Nach der Weiterentwicklung von Prozessen und der Überprüfung von Hardware und Software besteht die letzte Empfehlung darin, weiterhin wachsam zu sein und sich über die Fortschritte im Bereich Quantencomputing und Verschlüsselung auf dem Laufenden zu halten. Dies gilt auch für die Entwicklung neuer Designs oder die Aufrüstung bestehender Designs. Niemand kann mit Sicherheit sagen, wie sich die Technologielandschaft verändern wird, aber jeder ist davon überzeugt, dass Veränderungen bevorstehen. Verfolgen Sie die daher aufmerksam die Entwicklungen in der Branche (und reagieren Sie darauf).

Die PQC – das ist sicher!

Heutige Sicherheitslösungen funktionieren, weil die Rechenleistung, mit der sie kompromittiert werden können, noch nicht vorhanden ist. Es war schon immer bekannt, dass die Rechenleistung eines Tages die derzeitigen Sicherheitsvorkehrungen übersteigen und ein „Umdenken“ erforderlich sein würde. Die heutigen Verschlüsselungsverfahren lassen sich mit frühen Quantencomputern glücklicherweise (noch) nicht knacken. Doch dies wird schon bald möglich sein. Die Auffassungen gehen zwar auseinander, aber viele glauben, dass wir diesen Punkt innerhalb eines Jahrzehnts erreichen werden.

Das Umdenken hat jedoch bereits begonnen und wird von Organisationen wie dem NIST vorangetrieben. Die Entwicklung von Hardware, die Implementierung von Software und die Verbesserung der Nutzung werden noch einige Zeit in Anspruch nehmen. Doch in der Zwischenzeit kann schon heute viel getan werden, um sicherzustellen, dass die Systeme die größtmögliche Sicherheit bieten.