Verfolgt man die Geschichte der Konstruktionswerkzeuge, so gab es zuallererst eine Zeichnung am Reißbrett. Mit der Einführung von computergestützten Konstruktionsprogrammen (CAD) wurde dann der digitale Zwilling geboren – erst in 2D und dann in 3D. Dieser war anfangs ziemlich dumm, bestand er doch lediglich aus bemaßten Linien und Flächen, die sich zu einem Körper zusammensetzten.

Anfangs gab es in CAD-Programmen noch keine physikalische Beschreibung der Bauteile, mit deren Hilfe man den digitalen Zwilling virtuell zum Leben hätte erwecken können, das heißt seine Funktion vorab per Simulation zu prüfen. Simulationen waren damals noch das Hoheitsgebiet von Universitäten, welche mit Hilfe komplexer Algorithmen Prinzip-Studien zu Einzelfunktionen, nicht aber Gerätestudien durchführten. Erst mit der Einführung leistungsstarker Unix-Workstations beziehungsweise Windows-basierter PCs wurden professionelle 3D-Konstruktionsprogramme effizient und bezahlbar.

Material und Kosten sparen

Genau wie die Performance der Workstations und PCs seither rasant gewachsen ist, wurde auch der digitale Zwilling zunehmend smarter. Zur virtuellen Belebung und Prüfung wurden dem Zwilling immer mehr Informationen bezüglich der physikalischen Eigenschaften von Einzelobjekten in der Gerätebaugruppe zugewiesen. Der Vorteil liegt auf der Hand: Indem Abschätzungen zum Verhalten des digitalen Zwillings frühzeitig in Simulationen durchgeführt werden, spart man in der Entwicklungsphase Zeit und Kosten für den Prototypenbau und kann auf lange Mess-

reihen verzichten, die nur punktuelle Aussagen liefern.

Eine Simulation durch den digitalen Zwilling ermöglicht eine detaillierte Analyse, wenn nötig bis in die molekulare Struktur hinein. Man kann nicht nur die Funktion eines Geräts prüfen, sondern auch die Ursache für sein Funktionieren beziehungsweise Ausfallen erkennen. Aber nicht nur das: Die Simulationsergebnisse zeigen auch, ob die Funktion des Geräts gewährleistet wäre, wenn man an manchen Stellen noch Material einsparen, einen kleineren Lüfter einbauen, auf ein günstigeres Kunststoffgehäuse umsteigen oder den teuren Elektronikkomponenten mehr Leistung beziehungsweise Wärme zumuten würde.

Selbst grobe Simulationen steigern die Leistung

Am Beispiel der thermischen Simulation von Elektronikgeräten lässt sich der Entwicklungsweg des digitalen Zwillings besonders schön nachvollziehen. Die CFD-Simulationstechnik (Computational Fluid Dynamics) erhielt Ende der 1980er Jahre Einzug in die Elektronikindustrie. Damals wurde die Software noch auf Disketten ausgeliefert und war nur auf Unix-Systemen lauffähig. Dabei handelte es sich jedoch noch lange nicht um detaillierte Simulationen, wie wir es heute gewohnt sind. Damals wurde das Simulationsmodell noch aus Plattenobjekten zusammengebaut, welche durch die Eingabe von Koordinaten und nicht etwa per bequemen Mausklick erstellt wurden. An einen Import aus der CAD-Welt war noch nicht zu denken! Platinen waren einzelne Plattenelemente mit einer verteilten Gesamtverlustleistung, eingebaut in eine rechteckige Schachtel als Gehäuse. Ein paar Luftleitbleche konnte man noch als 2D-Objekte einfügen. Der Lüfter war eine Fläche mit festem, gerade ausströmendem Volumenstrom – der eigentlich noch unbekannte Arbeitspunkt des Lüfters musste also als Eingabewert vorausgesagt werden.

Dennoch half das Ergebnis solch grober Simulationen dabei, frühzeitig die Leistungsfähigkeit eines Geräts zu prüfen – im beschriebenen Fall, welche Verlustleistung bei diesem konstruktiven Aufbau aus dem Gerät abgeführt werden konnte. Optimierbar waren die Größen und Positionen der Luftöffnungen und der Volumenstromquelle sowie die PCB-Anordnung im Gerät.

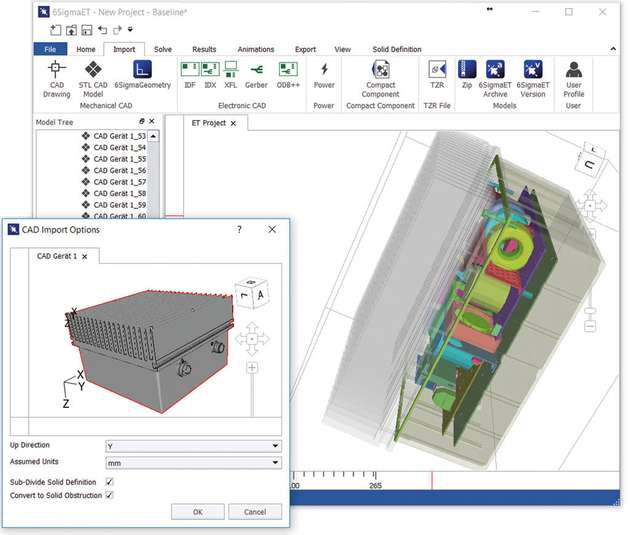

Mit wachsender Rechnerperformance wurden auch die Simulationen mit immer mehr Details „gefüttert“. An einen Layout-Import von Platinen war zwar Ende der 1990er Jahre noch nicht zu denken, aber auf einmal war der CAD-Import in aller Munde, das heißt die Übernahme komplexer Gehäuseformen und Geräteaufbauten aus dem CAD-Programm als Basis für die Simulation. Bis heute wird der CAD-Import bei verschiedenen CFD-Softwareanbietern sehr unterschiedlich unterstützt:

Manche Anbieter versuchen, die CFD-Welt direkt in das CAD-Werkzeug zu integrieren. In der Folge haben ihre Simulationsmodelle mit den komplexen Stolpersteinen eines CAD-Systems zu kämpfen.

Andere Anbieter benötigen eine extrem lange Vorarbeit, um das CAD-Modell zu vereinfachen und somit für das CFD-Tool importier- beziehungsweise simulierbar zu machen.

Wieder andere Anbieter können direkt in ihrem Simulationstool mit den komplexen CAD-Baugruppen umgehen, benötigen aber eine entsprechend hohe Rechnerperformance – was man an Ingenieurszeit spart, muss man in Rechenpower investieren.

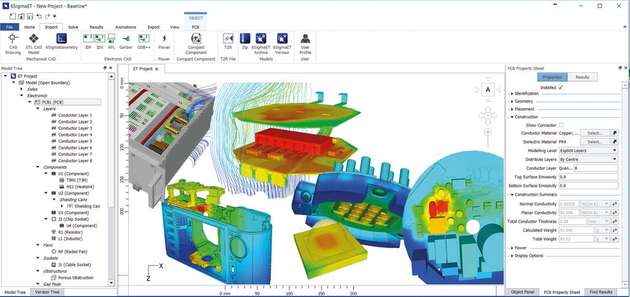

Die letzte Gruppe von Anbietern hat dabei den Vorteil, dass die Rechnerperformance noch immer von Jahr zu Jahr steigt und sich dennoch im Vergleich zu den Ingenieurskosten in einem bezahlbaren Rahmen bewegt. So ist ein guter Leistungs-PC mit 128 GB RAM, 4-GB-Grafikkarte und einer 16-Core-Doppel-CPU schon ab 5.000 € erhältlich. Im CFD-Programm 6SigmaET von Future Facilities wären damit Simulationen von bis zu 160 Millionen Knotenpunkten in den eingeschwungenen Zustand berechenbar, und das in überschaubaren Zeiten von 5 bis 8 Millionen Zellen pro Stunde.

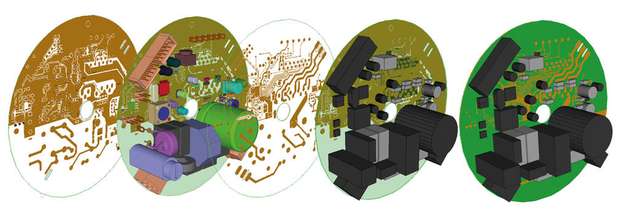

Mit dem Einzug des CAD-Imports rückte die Übernahme von Leiterplatinendaten in den Fokus der Aufmerksamkeit: Jetzt war es möglich, IDF-Daten zu importieren. Der Datensatz beinhaltete die Leiterplattengeometrie, die grobe Umrissgeometrie der Komponenten und die Position thermisch durchgehender Vias. Bei richtiger Datenpflege waren auch die Verlustleistung und der thermische Widerstand der Komponenten in den IDF-Daten enthalten. Die Lagenanzahl, -dicke und -position sowie eine Abschätzung der Kupferabdeckung pro Lage (in Prozent) mussten von Hand nachgepflegt werden. Zwar brachten Gerberdaten später noch die Anzahl der Signallagen und das Layout pro Signallage ins Modell ein, doch die Signallagendicke, die Lagenposition und auch die Mikro-Vias mussten nach wie vor händisch nachgetragen werden.

Platinendaten per Knopfdruck importieren

Dank neuer Datenformate wie beispielsweise ODB++ kann mittlerweile eine komplette Platine mit allen ihren Details per Knopfdruck in ein Simulationstool wie 6SigmaET importiert und in vollem Umfang für die Simulation genutzt werden. Weitere Erleichterungen bringen automatische Filter, die möglicherweise irrelevante Kleinstkomponenten herausfiltern können. Außerdem lässt sich das komplexe Platinenlayout mit seinen unzähligen Leiterbahnen per Knopfdruck in eine Bildbeschreibung umwandeln, deren einfaches Raster eine wesentlich performantere Simulation ermöglicht.

Neben der zunehmenden Detailtiefe der Simulationsmodelle wurde der digitale Zwilling aber auch durch ein umfangreicheres Repertoire an Material- und Umgebungsbeschreibungen aufgewertet. So ist es heutzutage möglich, jeden beliebigen Lüfter mit seiner Lüfter-Kennlinie zu integrieren und abhängig vom herrschenden Umgebungsdruck den richtigen Arbeitspunkt berechnen zu lassen. Zudem können die Simulationen transiente Vorgänge abbilden. Zum Beispiel kann der Lüfter durch einen Temperatursensor gesteuert werden, der Strom die Leiterbahnen aufheizen oder eine Anströmung aus der Umgebung variieren. Aktuelle CFD-Tools bieten auch erweiterte Modellbeschreibungen wie temperaturabhängige Verlustleistungen oder Materialwerte, Sonneneinstrahlung als zusätzliche Last für Outdoor-Geräte und vieles mehr.

Mittlerweile ist der digitale Zwilling fast schon realistisch geworden. Das „fast“ deutet an, dass es dabei auch Fallstricke zu beachten gibt. Eine Simulation ist nämlich nur so gut wie das zugrundeliegende Simulationsmodell. Dessen Qualität steht und fällt mit zwei Faktoren: Vernetzung und einer realistischen Modellbeschreibung.

Wie stellt man die Qualität des Netzes sicher?

Als Vernetzung beziehungsweise Netz bezeichnet man die mathematische Übersetzung eines Geräts für die CFD-Simulation. Für die Lösung aller mathematischen Formeln muss der Solver wissen, an welcher Stelle im virtuellen Simulationsraum ein Körper ist, aus welchem Material er besteht und wo dessen Flächen an einen anderen Feststoff oder ein Fluid grenzen. Zu diesem Zweck zerlegt das Netz den Simulationsraum in kleine Zellen, die über ihre X,Y,Z-Koordinaten Auskunft darüber geben können, wo sich eine bestimmte Zelle befindet und mit welchem Material/Fluid sie gefüllt ist. Daraus ergibt sich für den Solver ein digitales Bild des Geräts, aus dem er dann im virtuellen Betrieb das Energiegleichgewicht für den eingeschwungenen Zustand berechnet. Folgende Punkte sind beim Erstellen des Netzes unbedingt zu beachten:

Sind Fluidregionen mit großer Turbulenz gut aufgelöst?

Sind große Strömungsgeschwindigkeits- oder Druckgradienten gut aufgelöst?

Sind bei den Wärmeflüssen große Gradienten zu erwarten?

Wie geht das Netz mit dünnen Luftspalten oder Körperkollisionen um?

Unbedingt Toleranzen einberechnen

Der zweite Faktor, der die Qualität der Simulationsergebnisse stark beeinflusst, ist die realistische Beschreibung des Modells. Natürlich kann man zu Beginn einer Geräteentwicklung noch nicht zu jedem Detail eine klare Aussage treffen. Doch schon mit einer Toleranz von ±10 K lassen sich gute von schlechten Kühlkonzepten unterscheiden und entsprechend die richtigen Weichen stellen. Je mehr Details Einzug in das Modell erhalten, desto weniger unterscheiden sich die simulierten Ergebnisse von den später am Prototyp gemessenen Temperaturen. Natürlich kann eine Simulation den Prototypen niemals ganz ersetzen. Doch der erste Prototyp sollte aus thermischer Sicht keine Überraschungen mehr mit sich bringen, sondern lediglich die Simulationsdaten bestätigen. Da das Simulationsmodell aber niemals montagebedingte oder durch Materialtoleranzen zustande kommende Toleranzen wiedergeben kann, müssen selbst sehr gute Simulationsmodelle noch mit einer Toleranz von 1 bis 3 K bewertet werden. Dabei darf nicht vergessen werden, dass auch Messungen Toleranzen haben.

.jpg)

.jpg)